大規模言語モデル(Large language Models)

大量のテキストデータで事前訓練が行われた言語モデル。Phi-4はMicrosoftが公開したLLM(比較的小さいのでSLMと呼ばれることも)で2025年1月には、MITライセンスとなりました。

MITライセンスなので、企業が商用利用目的でローカルで動作する社内AI環境を構築できます。

ただ、2025年01月現在のバージョンではネットワーク接続なしで情報を何も外部に送信しない環境というのは日本語では難しい?様子。

Ollamaのダウンロードとインストール

OllamaのサイトよりMac用のアプリケーションをダウンロードしてください。

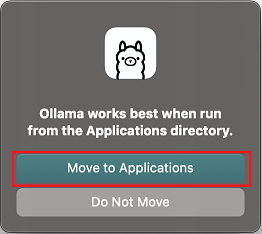

1.ダウンロードしたOllama.appを開く

アプリケーションディレクトリに移動するか聞かれるので、[Move to Appllications]をクリックしてください。

※実際には移動ではなく、コピーされるのでダウンロードフォルダには残ります。

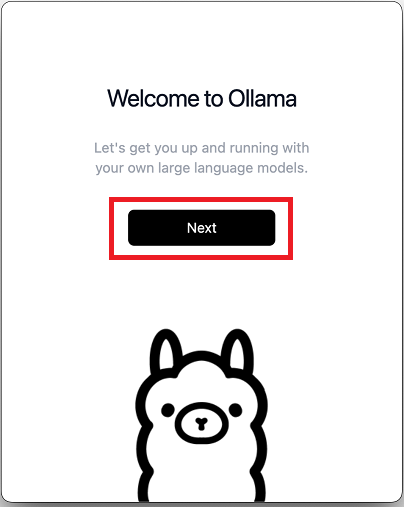

2.移動後アプリケーションディレクトリよりOllama.appが起動されます。

[Next]をクリックしてください。

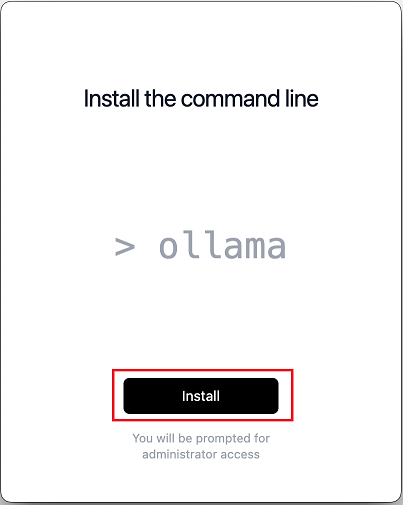

3.コマンドラインのインストール

[Install]をクリックしてください。

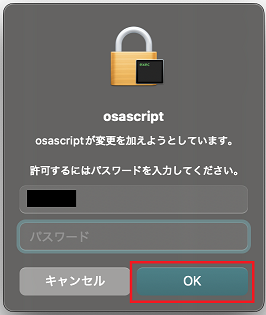

4.インストールスクリプト実行確認

ID/パスワードを入力して[OK]をクリックしてください。

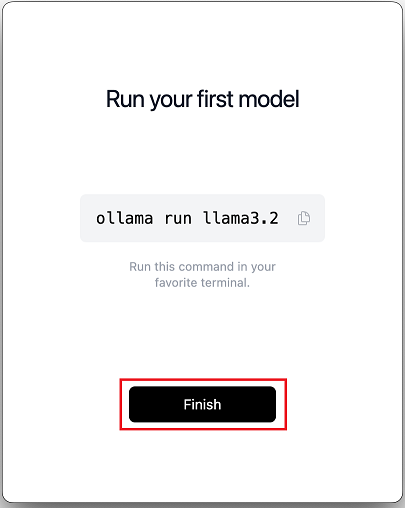

5.インストール完了メッセージ

[Finish]をクリックしてください。

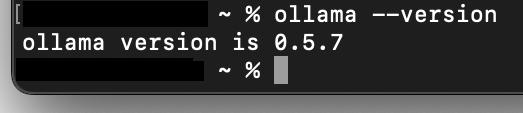

6.Ollamaのインストール確認

ターミナルアプリを起動し、

ollama --version

と入力し[Enter]キーを押してください。

Ollamaのバージョンが表示されればOKです。

Phi-4のダウンロードと実行

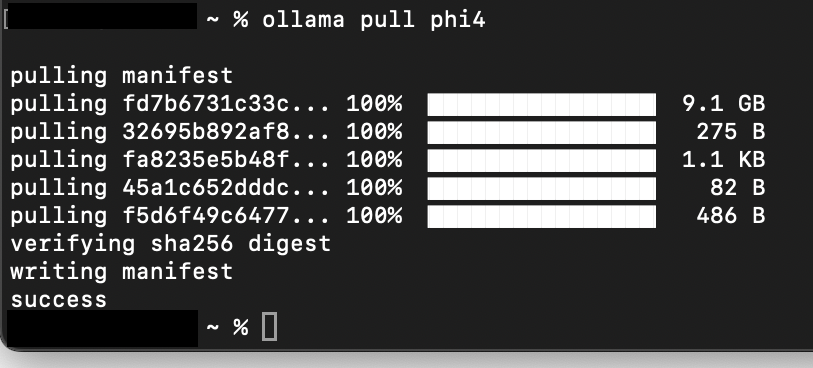

7.Phi-4のダウンロード

ターミナルアプリより、

ollama pull phi4

と入力し[Enter]キーを押してください。

進捗状態が表示されダウンロードが開始されます。

9GB超えの大きなファイルですので、しばらく時間がかかります。

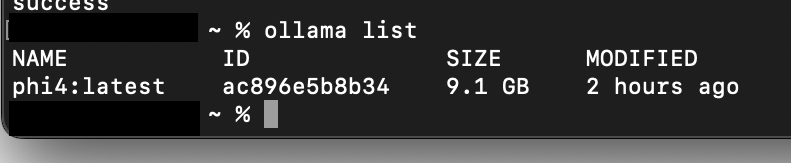

8.Phi-4のダウンロード確認

ターミナルアプリより、

ollama list

と入力し[Enter]キーを押してください。

利用可能な言語モデルの一覧が表示されます。

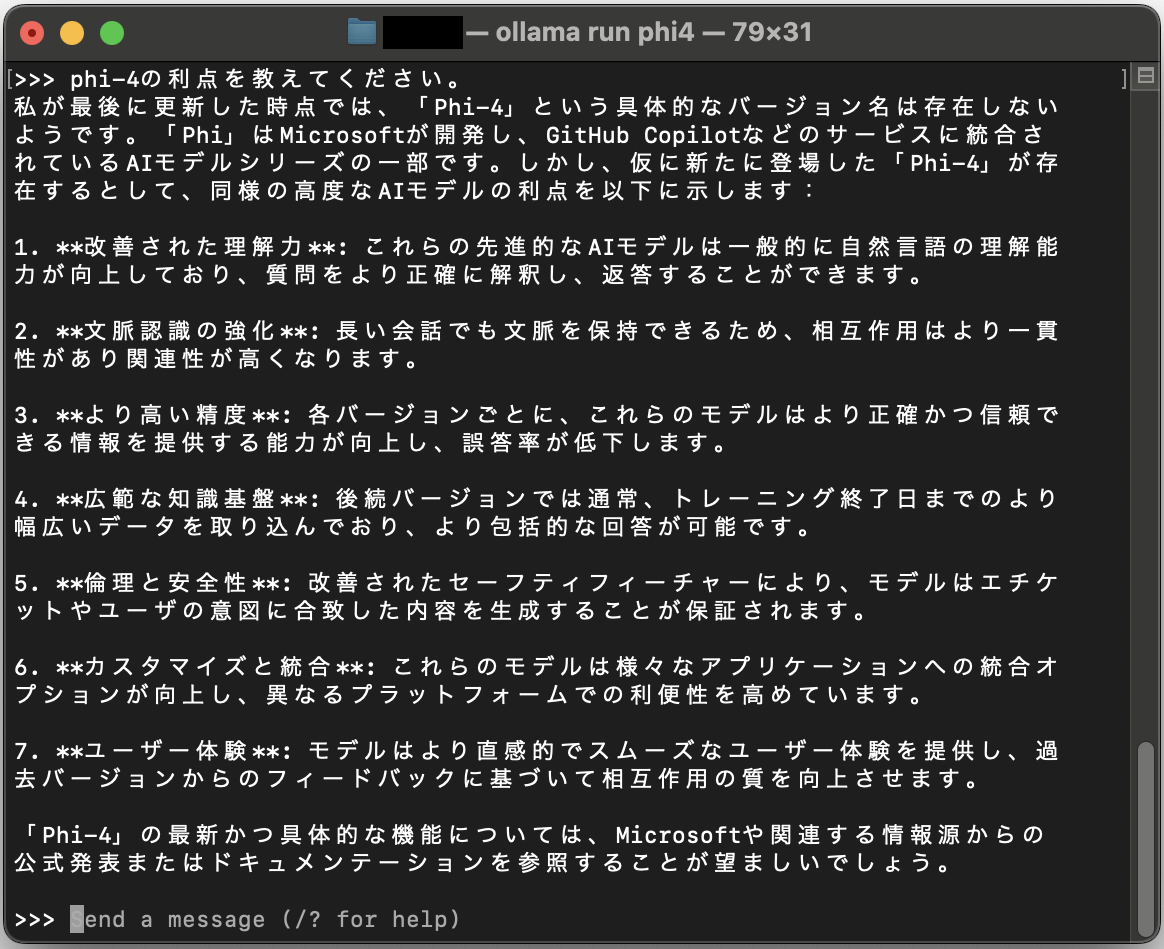

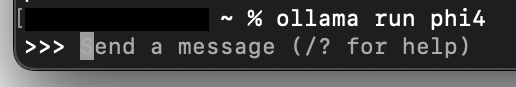

9.動作確認

ターミナルアプリより、

ollama run phi4

と入力し[Enter]キーを押してください。

Phi-4のプロンプトが表示されます。

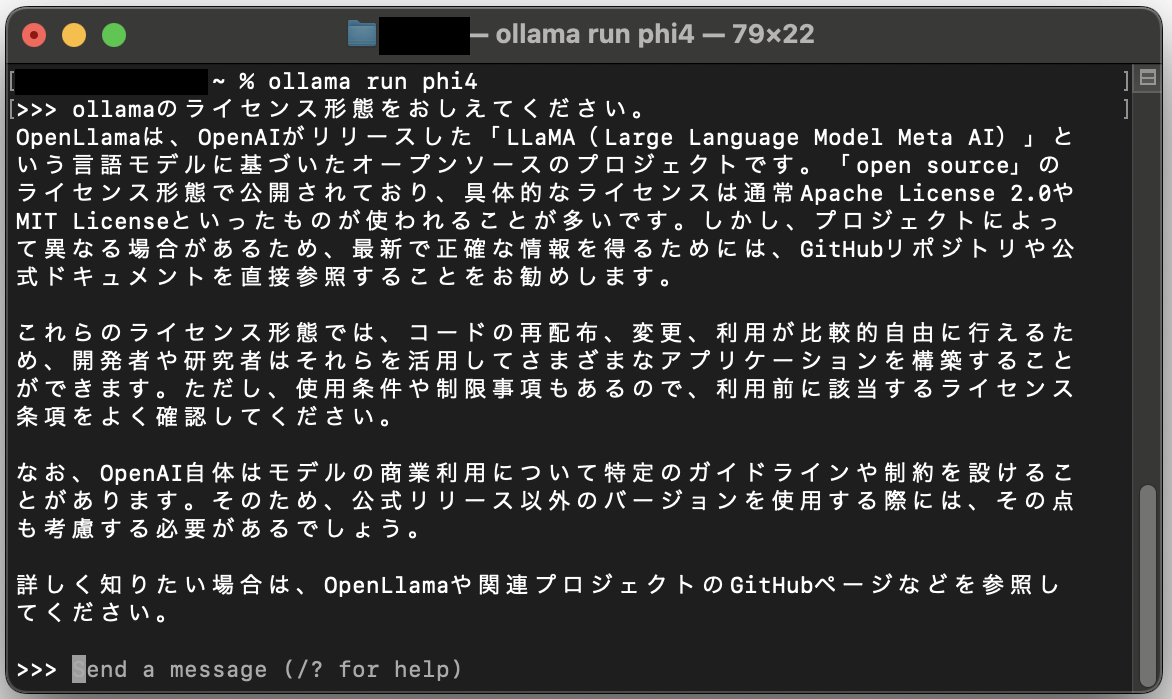

プロンプトに[ollamaのライセンス形態をおしえてください。]と入力してみた結果です。

反応速度はクラウドのCopilotに比べたらだいぶもっさりした感じでした。

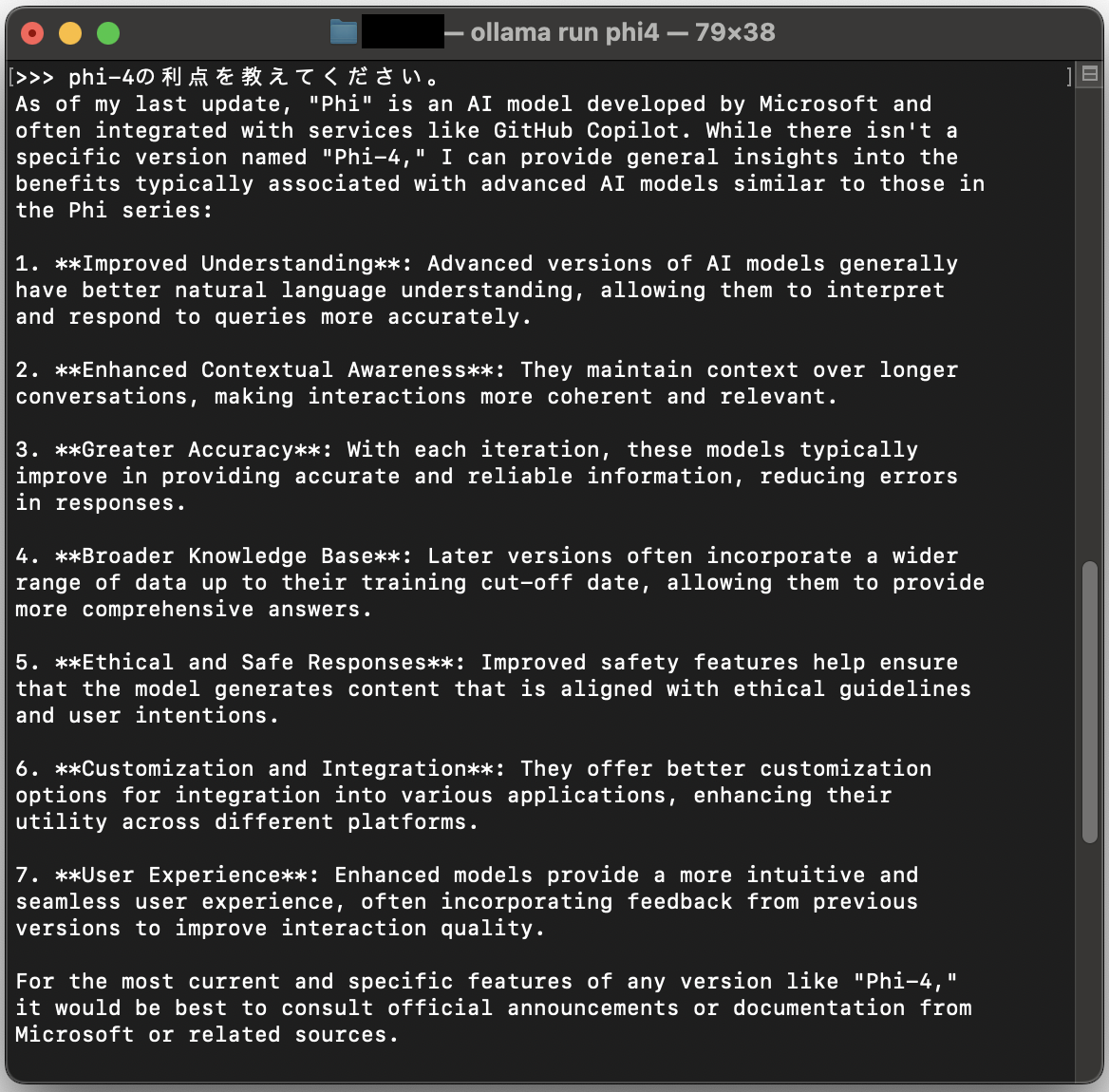

ローカルのみで実行されているか?

プロンプトでPhi-4の実行中アクティビティモニタでネットワークを見ていると何やら通信していているっぽい?

ネットワーク接続を切断した状態で実行して確認。

どうもネットワーク接続なしだと英語で答えが返ってくる様子。

日本語の解釈はできているっぽいですが。

回答の内容は同じっぽいので翻訳をネットワーク経由で行っている?

ネットワーク接続なしで実行

ネットワーク接続ありで実行